L’Artificial Intelligence applicata in ambito manifatturiero - Il caso Gnutti Carlo Spa

THE Ò-BLOG

Osservatorio AI 2020/2021 – Business Case

9 Marzo 2021

Tempo di lettura: 6 minuti

All’interno del lavoro fatto quest’anno con l’Osservatorio Artificial Intelligence, abbiamo avuto la possibilità di presentare un nostro case study al Politecnico di Milano (potete leggerlo qui: https://www.osservatori.net/it/prodotti/formato/business-case/artificial-intelligence-ambito-manifatturiero-gnutti-carlo-spa-business-case).

E’ stata l’occasione per sfatare alcuni miti e false convinzioni legate allo sviluppo di progetti di intelligenza artificiale (computer vision) nell’ambito manifatturiero, che emergono anche dal report della ricerca 2020-2021 dell’Osservatorio (qui potete leggere un nostro approfondimento: https://orobix.com/osservatorio-artificial-intelligence-ricerca-2020-2021/).

Il mercato italiano della computer vision è un segmento in costante sviluppo, ma solo il 30% delle aziende intervistate hanno un progetto in corso, di cui solo il 12% in fase esecutiva, mentre il restante 18% è in fase pilota o preliminare.

Secondo i dati dell’Osservatorio, la preparazione del dataset per avere dati di buona qualità e in quantità adeguata risulta complessa: il 65% delle aziende intervistate, considera altamente critica la fase di data integration, preparation e labelling che diventa uno dei freni all’avvio di progetti di AI, mentre per il 59%, le problematiche principali risiedono nella fase di costruzione del business case, dove l’incertezza sugli output incide nella definizione di requisiti, costi e benefici ottenibili.

MITO n.1: Creare un dataset è un’attività lunga e costosa

La creazione del dataset per allenare e validare una rete neurale è una tappa fondamentale all’interno di un progetto di Intelligenza Artificiale e, ad oggi, è anche uno degli ostacoli che limitano la diffusione dei sistemi di AI nelle nostre aziende.

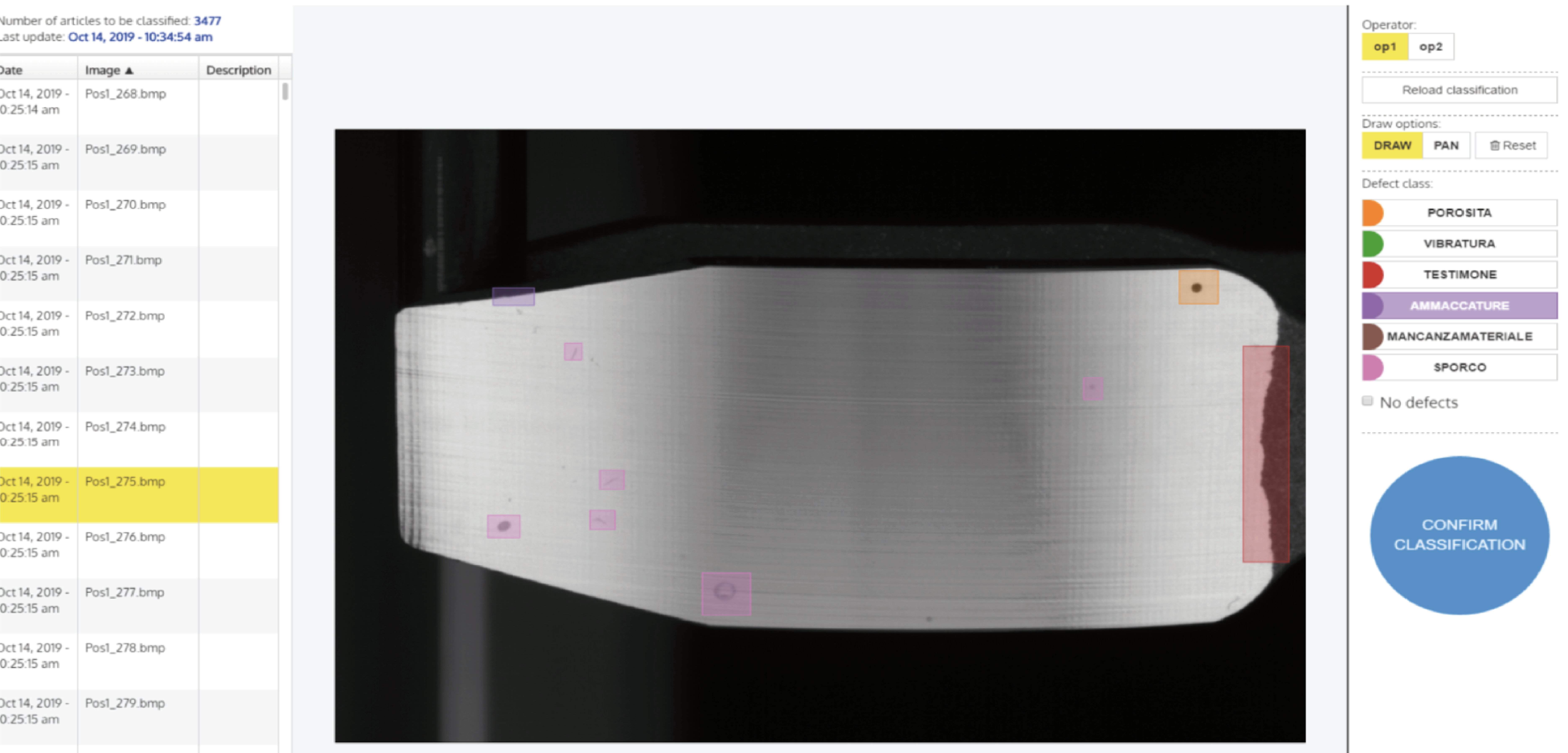

Nel business case analizzato (lo trovate anche qui: https://orobix.com/our-case-histories/anomaly-detection-automotive/), è stato fornito al cliente un annotatore, ovvero un software intuitivo e facile da usare che ha permesso di visualizzare le 1400 immagini già disponibili, contornare (in gergo tecnico “segmentare”) i difetti presenti e etichettarli (in gergo tecnico “taggare”) per dividerli nelle varie categorie.

Un’operazione solitamente molto onerosa che lo strumento ha permesso di ridurre a 10 ore uomo per la prima iterazione e altre 4 per la seconda.

Quindi come è possibile rendere la creazione del dataset più veloce ed efficace?

Ecco il nostro metodo:

1. fornire al cliente un sistema di annotazione che permetta di visualizzare, etichettare e salvare i dati in modo che siano automaticamente resi disponibili alla rete neurale;

2. affinare il dataset sulla base delle informazioni ricavate dal monitoraggio del modello in produzione: analizzando l'incertezza nel giudizio è infatti possibile pianificare campagne di annotazione mirate per fornire alla rete i dati necessari a migliorare le proprie performance, andando dritti al punto sui casi che il modello gestisce con più difficoltà.

MITO n.2: Tempi, costi e benefici di un progetto di AI sono difficili da definire e misurare

Chi si occupa di valutare la fattibilità di progetti di intelligenza artificiale deve per prima cosa riconoscerne la multidisciplinarietà che li posiziona a cavallo tra l’ambito IT, quello produttivo e quello organizzativo. Coinvolgere le persone giuste nella definizione dei requisiti e dei relativi KPI di valutazione è il punto fondamentale da cui partire.

Bisogna essere pronti a chiudere i progetti quando non emerge un chiaro beneficio dalle prime fasi e allo stesso modo bisogna avere la lungimiranza di andare in produzione il prima possibile per fare i conti con la variabilità del campo.

Nello specifico business case analizzato, il progetto con Gnutti Carlo Spa è durato 6 mesi di lavoro e da subito sono stati fissati obiettivi e KPI condivisi con il cliente.

Per prima cosa si è deciso di sviluppare una soluzione che permettesse di riutilizzare il banco di visione precedentemente acquistato, in modo da valorizzare l’investimento già fatto, così come il dataset di immagini delle difettosità già raccolto il passato.

In secondo luogo si è scelto di sviluppare un algoritmo che permettesse di distinguere i pezzi difettosi da quelli buoni ma anche di classificare le difettosità per tipologia (image classification) e localizzare l’anomalia in modo da renderla visibile all’operatore (image segmentation) al fine di poterne individuare l’origine e mettere in atto azioni correttive lungo la filiera.

I KPI di riferimento fissati per valutare la bontà della soluzione ideata sono i seguenti:

- il ROI, ovvero il ritorno di investimento che è stato valutato nel seguente modo: in fase di validazione, l’algoritmo è stato testato su un dataset di 10.000 componenti giudicati “scarto” dagli operatori; l’80% dei pezzi è stato riclassificato “buono” dall’AI (si tratta di casi per i quali gli operativi hanno dato giudizi cautelativi) e rimesso in commercio, consentendo così di ripagare quasi completamente l’investimento per la soluzione di AI.

- il livello di detectability: l’algoritmo riesce bene a individuare i difetti e discriminare tra difetti reali e aloni o sporco depositato. In fase di test, solo 5 pezzi sui 250 che hanno avuto un parere contrastante tra il sistema di AI e l’operatore sono stati giudicati “falsi buoni”, ma si tratta di casi estremamente dubbi anche per gli operatori esperti. Non sono quindi stati rilevati casi di difetti grossolani lasciati passare dal sistema.

Quindi, come è possibile rendere la definizione dei tempi, dei costi e dei benefici più efficace?

Ecco il nostro metodo:

1. partire da un’esigenza di business definita e sentita dall’azienda;

2. coinvolgere nel team di progetto le figure aziendali legate al processo in esame, in modo che siano rappresentati tutti i dipartimenti coinvolti, dall’IT alla produzione, alla strategia;

3. andare in produzione il prima possibile per confrontarsi da subito con la variabilità del campo;

4. fornire alle aziende strumenti per interagire con gli algoritmi, dalla fase di training all’inferenza in produzione;

5. fornire alle aziende strumenti di versionamento di dati e modelli e supportarli nella definizione delle adeguate procedure di validazione;

6. fornire alle aziende strumenti di monitoraggio real time delle performance;

7. fornire alle aziende strumenti automatici di active learning per incrementare nel tempo le performance dei modelli;

8. accompagnare il cliente nell’intero processo di adozione dell’AI, dall’identificazione del problema, fino al monitoraggio della soluzione messa in campo.

Vuoi approfondire altri progetti sui quali abbiamo lavorato?

Vai alla sezione our case histories.